Информация для бизнеса — один из ценнейших ресурсов. Это ярко описывает крылатое выражение «Кто владеет информацией, тот владеет миром». Поэтому владельцы бизнесов так заинтересованы в поиске инструментов для сбора и анализа данных.

Одним из таких инструментов является программа под названием «парсер». В этой статье мы расскажем вам, что это такое, изучим какие функции можно выполнять с помощью парсера и проведем обзор лучших программ для сбора и систематизации информации.

- Что такое парсер и парсинг простыми словами

- Парсинг и краулинг: отличия

- Пример парсинга

- Пример краулинга

- Законно ли использовать парсинг

- Какие задачи помогает решить парсер

- Виды парсеров

- Тип устройства

- Формат программы

- Задачи

- Парсеры для SEO-специалистов

- Где найти парсер под определенные задачи

- Плюсы и минусы парсинга

- Ограничения: почему бывает сложно парсить

- User-agent

- Robots.txt

- IP-адрес

- Капча

- Алгоритм работы парсера

- Как пользоваться парсером?

- Как парсить данные

- Как спарсить цену

- Как парсить характеристики товаров

- Как спарсить отзывы (с рендерингом)

- Как парсить структуру сайта

- Обзор лучших парсеров

- В виде облачных сервисов

- В виде компьютерных приложений

- В виде браузерных расширений

- Чек-лист по выбору парсера

- Коротко о главном

Что такое парсер и парсинг простыми словами

Парсер — это программа, с помощью которой можно собирать данные с указанных веб-страниц, анализировать их и объединять их в базы в различных форматах. Такой сервис избавляет пользователя от необходимости выполнения большого объема однотипных действий и экономит значительное количество времени и сил.

А парсингом называется сам процесс сбора данных — вручную или с помощью программы.

Парсинг и краулинг: отличия

Многие путают понятия парсинг и краулинг между собой. Это неудивительно, ведь принцип работы у них схожий – сканирование источников для сбора данных. Различаются только источники и тип данных, которые собирают программы.

При парсинге добывается любая информация – от номеров телефонов до каталогов цен. Программа для парсинга (или человек вручную) сканирует все открытые источники, чтобы собрать как можно больше данных. Задачи для такого инструмента могут быть самые разные, начиная со сбора статистики и заканчивая конкурентным анализом.

При краулинге специальный робот сканирует страницы в Сети, проверяя их на обновления и соответствие поисковым запросам. Поэтому сканирование осуществляется исключительно в поисковых системах, а сам инструмент применяется в основном для SEO-оптимизации сайтов.

Пример парсинга

Заказчик хочет провести анализ ценовой политики. Чтобы определить среднее значение стоимости товара, ему необходимо узнать информацию о стоимости данного товара. Эту задачу можно решить с помощью парсинга. Парсер просканирует сайты конкурентов и соберет необходимые данные о продукте.

Пример краулинга

Чтобы эта статья отображалась в поисковой видимости, краулер сканирует страницу сайта Zvonobot и добавляет ее в базу данных (индекс) поисковой системы.

Законно ли использовать парсинг

Некоторые считают, что парсинг — это незаконная деятельность. Но это не совсем так. Действительно, существуют некоторые ограничения, например, законом запрещено взламывать сайты, то есть извлекать конфиденциальные данные.

Но парсинг вполне законен, если он используется для сбора информации, которая находится в открытом доступе — и при желании её можно собрать и вручную. Программы-парсеры просто ускоряют этот процесс и предотвращают ошибки, связанные с человеческим фактором — например, создание данных-дубликатов, сбор «битых» ссылок и т. д.

Какие задачи помогает решить парсер

Парсер помогает бизнесу решать множество задач, например, с помощью парсинга можно:

- Собирать контакты клиентов. Многие контактные данные (номера телефонов, email, адрес) находятся в открытом доступе, а значит, извлекать их можно вполне законно. Однако для использования полученной информации в своих целях понадобятся дополнительные процедуры.

- Отслеживать ценовую политику. Если проводить анализ средних цен вручную, то это займет огромное количество времени. Парсинг позволяет узнавать не только усредненные параметры, но и нижнюю границу цен. А данные о минимальном значении цены на рынке пригодится для проведения акций и скидок.

- Быть в курсе текущих событий на рынке. Парсер помогает быстро и автоматически собрать информацию о товарных позициях с сайтов поставщика. Конечно, можно запросить информацию по товарам и у поставщика напрямую, но тогда придется вручную вносить данные о каждой товарной единице.

- Извлекать метаданные. SEO-специалисты, занимающиеся продвижением сайтов в поисковых системах, используют парсеры для проведения аудита веб-страниц. Благодаря парсингу, специалисты в области SЕО могут, например, копировать у конкурентов содержимое тегов Title, Description и Keywords.

- Проводить технический аудит сайта. Вебмастеры тоже нашли способ применения парсера в работе — выявление в автоматическом режиме нерабочих страниц и ссылок на сайте.

Виды парсеров

Парсеры разделяются на несколько групп в зависимости от целей и задач. Рассмотрим некоторые из них.

Тип устройства

| Облачный | Десктопный |

|---|---|

| Облачные сервисы, или «облака», — это сеть программ, которые позволяют клиентам пользоваться своими функциями через интернет. Облачные парсеры подойдут тем, кто регулярно парсит данные, потому что удобны в использовании: не нужно ничего скачивать, всю работу можно осуществлять «в облаке». В интернете можно найти как англоязычные, так и русскоязычные программы для парсинга. | Десктопные парсеры устанавливаются на компьютер. Некоторые программы можно запустить с внешних накопителей. Десктопная версия отличается большим количеством полезных функций, которых нет в облачных сервисах. Большая часть десктопных программ разработаны под Windows, так что на macOS их придется запускать с виртуальной машины. |

Формат программы

| Браузерная версия | Надстройка для Excel | Google Таблицы |

|---|---|---|

| Существует большое количество браузерных расширений и плагинов, с помощью которых можно собирать нужные сведения из выбранных интернет-ресурсов. Полученные данные можно сохранять в любом удобном формате, например, XML или XLSX. | Это программные продукты в виде виджета, созданного специально для Microsoft Excel (например, ParserOK и пр.) У такого ПО есть специальные макросы для выгрузки результатов в файлы форматов XLS или CSV. | В Google Таблицах есть две функции для выгрузки данных с веб-ресурсов — IMPORTXML и IMPORTHTML. Формула IMPORTXML парсит данные источников для сбора практически любых данных (заголовков, метаданных, ценовых показателей и пр.) Функция IMPORTHTML же позволяет собирать информацию из таблиц и списков на веб-порталах. |

Задачи

| Организаторы совместных покупок | Анализ цен конкурентов | Наполнение интернет-магазинов |

|---|---|---|

| Такие парсеры устанавливают на свои сайты производители товаров, чтобы любой желающий мог выгрузить весь продуктовый ассортимент сразу с сайта. Парсеры для организаторов совместных покупок имеют понятный интерфейс и функции, чтобы выгрузить конкретные товары, отдельные разделы или весь каталог целиком. | Парсеры для анализа ценовых предложений конкурентов подойдут всем, кому регулярно требуется отслеживать рыночную стоимость товаров. С помощью такого инструмента можно собрать ссылки на продукцию конкурентов, а также сравнивать их цены с существующими ценами компании. | Чтобы наполнить интернет-магазин товарами с сайтов производителей, нужно копировать названия и характеристики продукции, цены и изображения. Такую задачу можно сделать самостоятельно (если таких позиций немного). Но если их больше 100, то на внесение данных вручную не останется ни времени, ни сил. Для решения задачи подойдет парсер, с помощью которого можно в автономном режиме собирать нужные данные с сайтов-доноров. |

Парсеры для SEO-специалистов

Отдельную категорию занимают программы по сбору SEO-данных. Это узко- или многофункциональные программы, c помощью которых можно:

- анализировать содержимое файлов robots.txt и sitemap.xml, чтобы проверить их на правильность заполнения;

- проверять наличие мета-тегов (title, description и keywords) на страницах сайта, сравнивать их длину, собирать заголовки всех уровней (H1-H6);

- проверять HTTP (коды состояния) веб-страниц;

- собирать, визуализировать структуру интернет-ресурса;

- проверять атрибут alt на наличие описания под каждым изображением, так как этот параметр имеет важное семантическое значение и влияет на SEO-оптимизацию веб-страницы;

- анализировать оптимизацию ссылочной массы (внешнюю перелинковку и внутренние ссылки);

- отслеживать наличие битых, неработающих ссылок;

И выполнять множество других функций.

Где найти парсер под определенные задачи

Есть 3 способа, которые помогут получить полезную утилиту для поиска и анализа информации.

- Создать собственный парсер. Это способ поможет создать парсер под конкретные задачи и цели – даже самые специфические. Но он непростой и ресурсозатратный: придется выложить немалую сумму, чтобы оплатить работу программиста, который будет создавать парсер.

- Установить программу-парсер на компьютер. Такой вариант тоже будет стоить денег, но обойдется значительно дешевле, чем нанять стороннего программиста. Преимуществом такого подхода является быстрая реализация задачи. Не все приложения подойдут для решения определенных задач. Поэтому перед установкой стоит ознакомиться с функциями парсера и убедиться в том, что они соотносятся с поставленными целями.

- Использовать веб-сервис или браузерный плагин. Облачный сервис подходит для выполнения простых операций. Большинство таких плагинов находятся в бесплатном доступе. Однако браузерная версия имеет ограниченное количество функций, нежели десктопная программа.

Плюсы и минусы парсинга

Как у любой программы, у парсинга есть слабые и сильные стороны. К преимуществам можно отнести:

- Автоматизирование процесса работы. Ключевая задача парсера — снизить нагрузку на сотрудников за счет автоматизации бизнес-процессов. Благодаря этому, у специалистов остается больше времени на выполнение непосредственных обязанностей.

- Анализ большого объема данных. С помощью парсинга можно анализировать сотни и даже тысячи веб-страниц, что человек не в силах сделать самостоятельно – или будет делать очень долго.

- Выявление ошибок. Помимо того, что парсинг позволяет собирать и анализировать информацию со всего мира, программа также способна определять ошибки в базах, на сайте или на другом онлайн-ресурсе.

Среди недостатков можно выделить:

- Невозможность собирать информацию с сайтов, владелец которого запретил извлекать данные по IP-адресам.

- Туманный результат. Не всегда полученные данные соответствуют результату, который хотел пользователь. К примеру, менеджер спарсил базу, однако в процессе обзвона выяснилось, что клиенты нецелевые (то есть не заинтересованы в услугах компании). Как правило, это зависит от возможностей самой программы и качества настройки параметров для поиска.

Ограничения: почему бывает сложно парсить

Некоторые сайты используют специальные программы, которые закрывают веб-страницы от роботов. Таким образом владельцы интернет-ресурсов обеспечивают сохранность конфиденциальных данных и защиту уникального контента от злоумышленников.

Существует множество видов ограничений для парсинга — рассмотрим самые популярные из них.

User-agent

User-agent — это идентификационная строка, которая использует сетевой протокол для настройки доступа к сайту. При входе на веб-ресурс клиентское приложение отправляет серверу информацию о себе, чтобы отобразить информацию со страницы — HTTP-запрос выглядит, как текстовая строка и содержит в себе тот самый параметр User-agent.

Алгоритм защиты выглядит следующим образом: сайт получает много однотипных запросов с одним и тем же параметром User-Agent, сайт определяет, что это парсер и может на время заблокировать подобные запросы.

Robots.txt

Robots.txt — это текстовый файл в формате .txt, который содержит инструкции и параметры для поисковых роботов, запрещающие индексировать определенные файлы веб-страницы.

Владельцы сайтов в настройках robots.txt могут запретить для индексации конкретные веб-страницы.

IP-адрес

IP-адрес — уникальный числовой идентификатор устройства, работающей по протоколу IP.

Могут возникнуть подозрения, если с одного адреса регулярно поступают одинаковые запросы. Схема защиты сайта сходна с идентификационной строкой, только вместо параметра user-agent система отслеживает IP-адрес и блокирует подозрительные.

Капча

Капча (CAPTCHA) – это защитный код, который пользователю необходимо ввести на сайте, чтобы защитить страницу от действия автоматических программ (роботов, спама, флуда и др.). Большинство онлайн-ресурсов при возникновении подозрения на атаку злоумышленников предлагают пройти капчу.

Алгоритм работы парсера

Процесс работы программы различается исходя из целей и задач, но общая схема обычно имеет следующую структуру:

- В программу вводятся исходные параметры для поиска.

- Парсер ищет информацию на конкретных сайтах или по всей глобальной сети.

- Сервис систематизирует полученные сведения в единую базу.

- Создается отчет в наиболее удобном для пользователя формате.

Обычно процесс парсинга занимает от 5 минут до 1 часа. Это зависит от исходных параметров, которые были установлены для работы.

Как пользоваться парсером?

Процесс поиска информации основан на исходных параметрах, которые указал пользователь. Чтобы на выходе получить нужный результат, важно основательно отнестись к выбору вводных величин.

Например, если пользователь указал не те интернет-ресурсы, откуда хотел извлечь необходимые данные, то выхлоп от парсинга будет равняться нулю.

Также перед тем как начать работать с парсером, нужно определиться с целью. Это может быть проведение технического аудита веб-страниц, актуализация данных или проведение анализа конкурентов, на основании которого можно собрать информацию для сайта компании.

Как парсить данные

Парсить данные можно тремя способами: c помощью готовых программ по сбору данных, разработки собственного приложения-парсера и вручную.

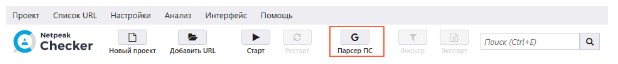

Рассмотрим пример парсинга с помощью готовой программы Netpeak Checker. Предположим, что перед нами стоит следующая задача: спарсить контакты потенциальных клиентов. Для этого можно воспользоваться функцией «Парсер поисковых систем».

Далее необходимо ввести список ключевых слов (запросов). Например, мы продаем оборудование для бьюти-индустрии и хотим спарсить контакты салонов красоты и парикмахерских.

Каждый ключевой запрос вводим с новой строки. Если ключ состоит больше чем из одного слова, то ставим между словами знак “+”.

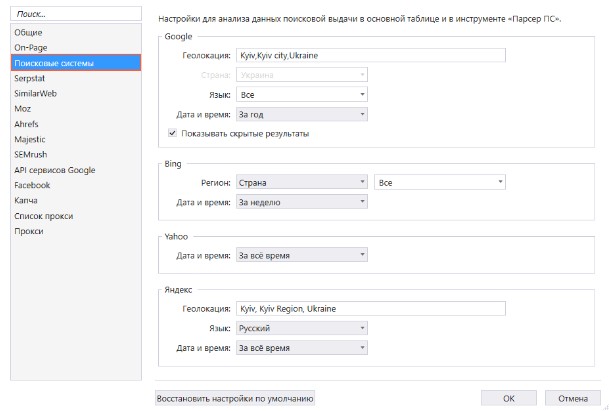

После выполнения вышеперечисленных действий нужно перейти на вкладку «Настройки» и геолокацию, чтобы получить выборку только из нужного нам региона.Также указываем поисковую систему, в которой будет совершаться парсинг. На данный момент сервис работает с четырьмя крупнейшими поисковыми системами — Яндекс, Google, Bing и Yahoo.

После выбора параметров настройки нажимаем на кнопку «Ок», чтобы сохранить данные, и нажимаем на кнопку «Старт», чтобы начать процесс парсинга.

Спустя некоторое время программа высветит список сайтов. Чтобы выбрать страницы с номерами, нужно нажать кнопку «Перенести хосты» — после этого все ссылки отобразятся в таблице.

В разделе параметров «On-Page» выбираем пункт «Телефонные номера» — телефоны будут выгружены со страниц в таблицу. Скачать базу в формате .csv можно, нажав на кнопку «Экспорт».

Как спарсить цену

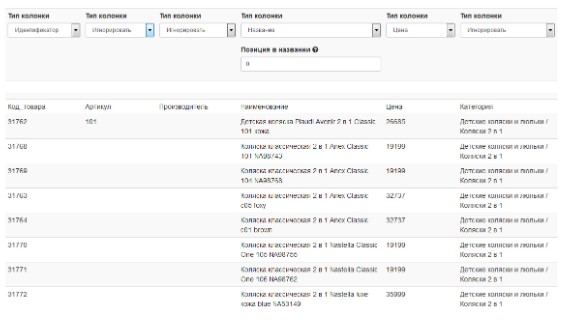

С этой задачей поможет утилита Marketparser. Она в автоматическом режиме соберет необходимые данные, например, стоимость продуктов. Для этого потребуется указать в программе код товара.

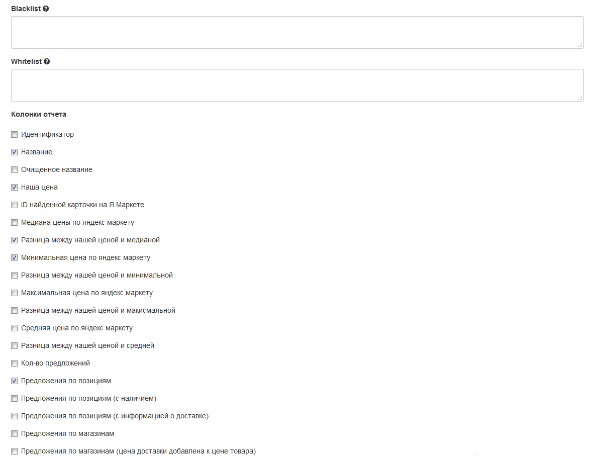

Следующим этапом необходимо выбрать парсер экспорта. Здесь можно задать регионы для поиска цен, внести магазины в черный или белый список, а также выбрать колонки для отчета.

Парсер предоставляет большое количество параметров в колонках отчета. Например, программа может в автоматическом режиме посчитать разницу между магазином и средней ценой по рынку (медианой), найти максимальные и минимальные цены товаров, а также определить общее количество предложений.

Как парсить характеристики товаров

Приложение Catalogloader, которое помогает интернет-магазинам собирать данные о товарах, отлично подойдет для решения этой задачи.

Сервис позволяет автоматически выполнять следующие задачи:

- наполнять категории сайтов с помощью парсинга информации у конкурентов,

- искать релевантный контент для интернет-магазина (характеристики продукции, фото, описание);

- добавлять товары в базу магазина с ценами;

- актуализировать стоимость продукции;

- обновлять товарный ассортимент;

- парсить информации с сайтов на различных CMS;

- обновлять данных на основе прайс-листов поставщиков;

- актуализировать данных с файлов Excel – товарный остаток, цена, информация;

- добавить десятки тысяч товаров за небольшой промежуток времени.

Чтобы использовать программу, её нужно установить на компьютер. Для начала парсинга нужно авторизоваться и создать новый проект.

Адреса для парсинга и его скорость указываются в разделе «Настройки». Там же можно установить уровень автономности парсинга — чтобы он запускался автоматически или только после разрешения пользователя.

Чтобы скачать данные с выбранных сайтов, нужно нажать кнопку «Запустить парсер», а затем выбрать категории для выгрузки и нажать кнопку «Запустить».

Для экспорта полученной базы нужно нажать кнопку «Открыть экспорт», выбрать категории, формат файла, путь на диске и нажать «Запустить».

Как спарсить отзывы (с рендерингом)

Алгоритм поиска и извлечения отзывов на сайте схож с парсингом товаров. Первым шагом нужно открыть программу и вставить в нее коды элементов.

Второй этап — сообщить программе, на каком языке программирования написан рендеринг (отрисовка), например, на JavaScript. Это нужно, чтобы утилита видела элементы сайта, которые появляются на экране только при прокрутке веб-страницы — чаще всего это блок с отзывами.

Таким образом некоторые сайты пытаются защититься от парсинга, но благодаря современным программам, это не является проблемой.

Как парсить структуру сайта

Многие используют парсер для сбора информации о структуре интернет-ресурса. Чтобы выяснить, как устроены сайты конкурентов или поставщиков, парсят элементы навигационной цепочки (breadcrumbs). Для этого нужно:

- навести курсор на любой элемент breadcrumbs;

- нажать ПКМ (правую кнопку мыши) и повторить действия по копированию XPath (инструмент запросов к элементам XML-документа).

Затем такую же операцию нужно выполнить для других элементов структуры.

Обзор лучших парсеров

Рассмотрим популярные приложения для парсинга в зависимости от типа устройства: десктопная, облачная или браузерная версия.

В виде облачных сервисов

Сюда можно отнести такие программные решения как:

- Import.io – это онлайн-платформа, с помощью которой можно получать данные со страниц сайтов из Интернета. Для работы с приложением не требуется знание языков программирования. Экспорт результатов можно настроить в форматах Excel, CSV, NDJSON.

- Mozenda – одна из старейших облачных программ, которой доверяют крупные компании (например, производитель электромобилей Tesla). Благодаря этому сервису, можно парсить с сайтов динамический контент, копировать шаблоны популярных сайтов, а также настраивать ротации IP-адресов. Есть возможность заказать парсер или купить готовое решение.

- Octoparse — один из самых известных и простых систем для сбора и анализа данных. Облачный сервис имеет визуальный интерфейс парсинга и не требует специальных знаний. Программа не ограничивает количество страниц для парсинга, интегрируется с API-системами и позволяет работать в облаке 24/7.

- Diffbot — современный инструмент, использующий машинное обучение и компьютерное зрение (анализ изображений и видео с помощью искусственного интеллекта) для поиска и извлечения информации. Благодаря функции «Analyze API», сервис может в автоматическом режиме определять тип страницы и собирать любую информацию: характеристики товаров, статьи, отзывы, видео и изображения.

В виде компьютерных приложений

Большинство десктопных парсеров поддерживается только на Windows, поэтому для запуска на операционных системах macOS или Linux придется воспользоваться виртуальными машинами и платформами.

Примеры десктопных приложений для парсинга:

- ParserOk – приложение для парсинга различных типов данных. Можно извлекать данные о стоимости товаров, номеров, электронные почты и т. д. Импорт данных в таблицы Microsoft Excel происходит с помощью макросов VBA, предназначенных для выполнения заданной последовательности действий. Надстройка проста в использовании, не требует знание языков программирования.

- Screaming Frog SEO Spider – многофункциональный сервис, специализирующийся на работе с SEO-данными. Инструмент позволяет не только собирать полезные данные для продвижения сайта (заголовки H1-H6, метаданные), но и проводить аудит сайта (отслеживать битые ссылки, находить дубликаты страниц и многое другое).

- Netpeak Spider — это программа, осуществляющая сканирование сайтов и анализ параметров в режиме реального времени. В приложении есть большое количество полезных инструментов для SEO-специалистов: сбор данных о сломанных ссылках, некорректно заполненных метаданных, скорости загрузки страниц и т. п.

- Datacol – универсальный парсер, который способен автоматически собирать самые разнообразные данные с различных веб-сайтов. С помощью сервиса можно парсить информацию из интернет-магазинов, досок объявлений, контентных сайтов, и социальных сетей.

В виде браузерных расширений

Браузерное расширение является удобным вариантом для работы, но при этом имеет существенный недостаток — небольшое количество функций по сравнению с десктопной или облачной версиями.

Ниже представлены расширения-парсеры, которые сыскали наибольшую популярность у пользователей:

- Parsers – плагин для извлечения HTML-данных со страниц, чтобы импортировать их в удобный формат (excel, xls, xlsx, csv, json, xml). Для определения страниц для парсинга сервис использует машинное обучение. Возможна интеграция по API.

- Web Scraper – расширение для парсинга, который упрощает извлечение данных со страниц сайта. Для настройки парсера используется визуальный редактор, навыки программирования не требуются. Сервис может собирать данные с веб-порталов с несколькими уровнями навигации (категориями, подкатегориями, пагинациями, страницами).

- Data Scraper – дополнение, извлекающее данные из любых HTML-кодов. Плагин предоставляет множество дополнительных функций (поддержка разных языков программирования, автоматический переход на следующую страницу), а также поддерживает следующие форматы для экспорта файлов: XLS, CSV, XLSX и TSV.

- Agent – продукт, позволяющий собирать данные из большинства источников. Парсер в виде браузерного расширения имеет ключевой недостаток – низкая производительность работы, поэтому Agent подходит только для парсинга информации в небольших объемах. Сервис предоставляет бесплатную версию на 14 дней.

Чек-лист по выбору парсера

Этот небольшой чек-лист поможет легче определиться с выбором подходящего сервиса.

- Поставьте цели и задачи, которые вы хотите решить с помощью парсера. Это может быть анализ конкурентов, сбор метаданных или наполнение каталога товаров.

- Установите итоговые результаты: какой объем информации и в каком формате нужно получить.

- Определите частоту сбора данных – единоразово, ежедневно, еженедельно и т. д.

- Выберите несколько парсеров в зависимости от поставленных задач. Протестируйте услуги сервисов (многие парсеры предоставляют бесплатную демо-версию), а также работу техподдержки: задайте вопросы и проверьте, насколько быстро менеджер свяжется с вами.

- Соберите данные в таблицу для анализа.

- Используя собранную информацию, подберите для себя наиболее подходящий парсер по соотношению цены и качества.

Коротко о главном

Парсер — полезный инструмент для бизнеса. С его помощью можно выполнять много полезных операций: актуализировать цены, собирать SEO-данные, проводить аудит сайта и многое другое.

Программы для сбора и анализа данных разделяются на несколько видов в зависимости от типа устройства (облачный, десктопный), формата программы (браузерная версия, надстройка для Excel, Google таблицы) и задач (для организаторов совместных покупок, анализа цен конкурентов и наполнения онлайн-магазина).

К главным преимуществам парсера можно отнести автоматизированный процесс работы, анализ большого количества данных и определение ошибок. Из недостатков можно выделить ограничение по сбору данных, если владелец онлайн-ресурса запретил извлекать информацию. Также к минусам относится непонятный результат, потому что не всегда собранные данные соответствуют ожиданиям пользователя.

Парсинг считается вполне легальным, если извлекать данные из открытых источников, где информацию можно собрать и вручную. Законом запрещено взламывать сайты, чтобы извлекать данные, доступ к которым ограничен.

Чтобы эффективно парсить данные, необходимо правильно подобрать программу-парсер и выбрать настройки в зависимости от поставленной цели. Если все сделать верно, парсер станет бесценным помощником в работе, значительно ускорит работу и сбережет силы сотрудников компании.